KKT条件、双対問題、カーネル関数が登場。前半の講義最後の山場っぽい。

第七回授業メモ

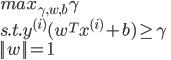

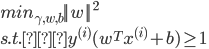

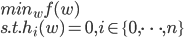

最適マージン分類器の同値な問題定義の方法

一つ目の定義

二つ目の定義

三つ目の定義

三つ目の定義は他の二つと違い、目的関数を最小化する。だけどこの式はどこから出てきたのかが問題。

Lagrange multiplier(ラグランジュ未定乗数法)とDual Problem(双対問題)

講義資料cs229-notes3.pdfの八ページからの内容。明らかに重要な箇所。ラグランジュ未定乗数法*1を導入する。省略。

そして双対問題の考え方も導入する。

- Constrained Control and Estimation > Lecture slides > Duality (Chapter 2)

が参考資料としていいかもしれない。

KKT条件を講義27:30ころから紹介。しかし以前以下の記事にメモしたのでここでは省略。

最適化:非線形計画+組み合わせ最適化のまとめのメモ - 雑なメモ

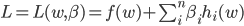

以下のような形の最適化問題を考えるとする。

このときにLagrangianと呼ばれる式Lを

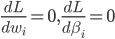

と定義する。特にこの式の中の係数 はラグランジュ乗数と呼ばれる。この式を偏微分して

はラグランジュ乗数と呼ばれる。この式を偏微分して

とするように を求める。結局、制約条件

を求める。結局、制約条件 に対してLagrange multiplier

に対してLagrange multiplier  を与えてこれらを係数とする線形結合である新しい関数

を与えてこれらを係数とする線形結合である新しい関数 を作れば、元の問題の「最適解を求める問題」は「関数

を作れば、元の問題の「最適解を求める問題」は「関数 の極値を求める問題」に置き換えられるということ。しかしこれでは等式の制約条件だけを持つ最適化問題しか解けないから、不等式の制約条件を持つ問題も解けるように一般化する必要がある..。そのためには何をすればいいだろうか。

の極値を求める問題」に置き換えられるということ。しかしこれでは等式の制約条件だけを持つ最適化問題しか解けないから、不等式の制約条件を持つ問題も解けるように一般化する必要がある..。そのためには何をすればいいだろうか。

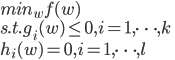

以下のような問題を定義してそれをprimal optimization problem(主最適化問題)と呼ぶことにする。

つまりkこの不等式制約とl個の等式制約条件がある一般的な最適問題を書いたのがこの式。そして一般化ラグランジュ関数Lを

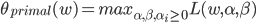

と記述する。 はラグランジュ乗数と呼ばれる係数。 そして以下の式

はラグランジュ乗数と呼ばれる係数。 そして以下の式

を考える。

書きかけです。講義44:22頃まで。

情報源及び出典、参照元

- Stanford engineering everywhere artificial intelligence | machine learning

- Stanford School of Engineering - Stanford Engineering Everywhere

- 講師:Andrew Ng (敬称略) 、著作権表示及び授業関連資料は上記サイトを参照してください。

- この記事の中の図の引用元

- Stanford School of Engineering - Stanford Engineering Everywhere

- それぞれの引用した図で、引用元(上記ページのpdfファイル名)を明記します。

- Stanford engineering ever に関するFAQ

- http://see.stanford.edu/see/faq.aspxを参照して下さい。

- 元サイトの著作権表示 Attribution 3.0 United States (CC BY 3.0 US) の日本語訳はここにありますが、誤解が無いように必ず英語ページを見てください。そして、この記事も同様にCC BY 3.0 USに従います。

※上記のページおよびpdf、上記以外の参考文献や関連ページを注釈の形でページ末尾に改めて記載します。